01. Faster RCNN

1. Faster RCNN의 구조

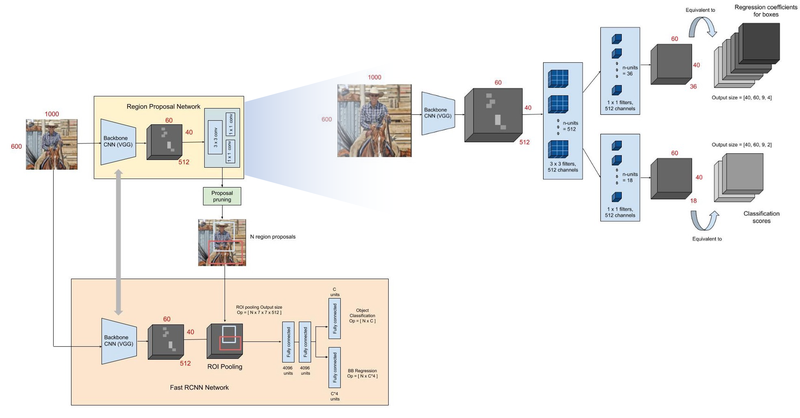

- RCNN, Fast RCNN과 Faster RCNN의 가장 큰 차이점

- Selective Search를 Region Proposal Network(RPN) 로 바꿈.

- RPN : RoI가 될 후보군인 Anchor Box를 무수히 만든다.

- 그 후 Bounding Box Regression를 통해서 괜찮은 RoI를 딥러닝을 통해 학습한다.

- Classification을 통해 그것이 Object인지 아닌지를 판단한다.

- RPN을 통해 얻은 결과에 Object Classification을 통해서 해당 RoI에 있는 Object가 어떤 Class인지 구분하고, Bounding Box Regression을 실행한다.

02. 실습

# Tensorflow와 Tensoflow Hub에 있는 이미 학습된 모델을 활용하기 위한 모듈

import tensorflow as tf

import tensorflow_hub as hub

# 이미지를 다운로드하는 데에 사용하는 모듈

import matplotlib.pyplot as plt

import tempfile

from six.moves.urllib.request import urlopen

from six import BytesIO

# 이미지에 선과 폰트를 넣기 위한 모듈

import numpy as np

from PIL import Image

from PIL import ImageColor

from PIL import ImageDraw

from PIL import ImageFont

from PIL import ImageOps

# Detection하는 데에 소요된 시간을 점검하기 위한 모듈

import time

- 이미지 시각화 하는 함수

def display_image(image):

fig = plt.figure(figsize=(20, 15))

plt.grid(False)

plt.imshow(image)

# 이미지를 resizing하는 함수

def download_and_resize_image(url, new_width=256, new_height=256, display=False):

_, filename = tempfile.mkstemp(suffix=".jpg")

response = urlopen(url)

image_data = response.read()

image_data = BytesIO(image_data) # 이미지 읽기

pil_image = Image.open(image_data)

pil_image = ImageOps.fit(pil_image, (new_width, new_height), Image.ANTIALIAS) # 이미지 조정

pil_image_rgb = pil_image.convert("RGB") #RBG로 변환

pil_image_rgb.save(filename, format="JPEG", quality=90) # 이미지 저장

print("Image downloaded to %s." % filename)

if display:

display_image(pil_image)

return filename

- Bounding Box를 만드는 함수

def draw_bounding_box_on_image(image,

ymin, xmin, ymax, xmax,

color,

font,

thickness=4,

display_str_list=()):

draw = ImageDraw.Draw(image)

im_width, im_height = image.size

(left, right, top, bottom) = (xmin * im_width, xmax * im_width,

ymin * im_height, ymax * im_height)

# BBox 테두리 그리기

draw.line([(left, top), (left, bottom), (right, bottom), (right, top),

(left, top)],

width=thickness,

fill=color)

display_str_heights = [font.getsize(ds)[1] for ds in display_str_list]

total_display_str_height = (1 + 2 * 0.05) * sum(display_str_heights)

if top > total_display_str_height:

text_bottom = top

else:

text_bottom = top + total_display_str_height

for display_str in display_str_list[::-1]:

text_width, text_height = font.getsize(display_str)

margin = np.ceil(0.05 * text_height)

draw.rectangle([(left, text_bottom - text_height - 2 * margin),

(left + text_width, text_bottom)],

fill=color)

draw.text((left + margin, text_bottom - text_height - margin),

display_str,

fill="black",

font=font)

text_bottom -= text_height - 2 * margin

- 이미지 위에 class 이름과 score를 나타내는 함수

# BBox 그리기

def draw_boxes(image, boxes, class_names, scores, max_boxes=10, min_score=0.1):

colors = list(ImageColor.colormap.values())

try:

font = ImageFont.truetype("/usr/share/fonts/truetype/liberation/LiberationSansNarrow-Regular.ttf",

25)

except IOError:

print("Font not found, using default font.")

font = ImageFont.load_default()

# BBox 그리기 적용

for i in range(min(boxes.shape[0], max_boxes)):

if scores[i] >= min_score:

ymin, xmin, ymax, xmax = tuple(boxes[i]) # 박스 좌표값

display_str = "{}: {}%".format(class_names[i].decode("ascii"),

int(100 * scores[i]))

color = colors[hash(class_names[i]) % len(colors)]

image_pil = Image.fromarray(np.uint8(image)).convert("RGB")

draw_bounding_box_on_image(

image_pil,

ymin,

xmin,

ymax,

xmax,

color,

font,

display_str_list=[display_str])

np.copyto(image, np.array(image_pil))

return image

- 이미지 불러오기

image_url = "https://upload.wikimedia.org/wikipedia/commons/thumb/d/db/Torneo_beach_handball.jpg/640px-Torneo_beach_handball.jpg"

downloaded_image_path = download_and_resize_image(image_url, 1280, 856, True) # new_width와 new_height를 변경해 보세요.

- pretrained 된 faster RCNN모델 사용

# tfhub에서 Pre-trained 모델을 사용

module_handle = "https://tfhub.dev/google/faster_rcnn/openimages_v4/inception_resnet_v2/1"

detector = hub.load(module_handle).signatures['default'] # detector에 사용할 모듈 저장

def load_img(path):

img = tf.io.read_file(path)

img = tf.image.decode_jpeg(img, channels=3)

return img

- Detector 실행함수

def run_detector(detector, path):

img = load_img(path)

converted_img = tf.image.convert_image_dtype(img, tf.float32)[tf.newaxis, ...]

# 소요시간 측정

start_time = time.time()

result = detector(converted_img)

end_time = time.time()

result = {key:value.numpy() for key,value in result.items()}

# 이미지 추론 개수와 추론 시간 출력

print("Found %d objects." % len(result["detection_scores"]))

print("Inference time: ", end_time-start_time)

# 이미지 내 박스로 entity, scores를 추가하여 출력

image_with_boxes = draw_boxes(

img.numpy(), result["detection_boxes"],

result["detection_class_entities"], result["detection_scores"])

display_image(image_with_boxes)run_detector(detector, downloaded_image_path)

'하루 30분 컴퓨터 비전 공부하기' 카테고리의 다른 글

| Vision Linear Classifiers가 입력 데이터를 처리하고 결과를 해석하는 방식 (1) | 2024.12.06 |

|---|---|

| CV(10) Image Classification/코드 실전편 (0) | 2023.10.31 |

| CV(8) Segmentation과 U-Net (0) | 2023.10.31 |

| CV(7) Object Detection과 R-CNN (0) | 2023.10.27 |

| CV(6) CNN 정복하기 - Transfer Learning 기본 (1) | 2023.10.27 |